Proyecto Superalineación de OpenAI Domando a los inteligentes superinteligentes del futuro

El equipo de supraalineación, liderado por el científico jefe de OpenAI Ilya Sutskever, desarrolla un método para dirigir el avance de los modelos de IA a medida que se vuelven más inteligentes.

Ilya Sutskever de OpenAI tiene una estrategia para controlar la IA superinteligente.

OpenAI, la compañía que se esfuerza por construir inteligencia artificial para el beneficio de la humanidad, ha presentado recientemente su grupo de investigación Superalignment. Este equipo está dedicado a gestionar y controlar los potencialmente peligrosos modelos de IA superinteligentes que se acercan rápidamente. Leopold Aschenbrenner, un investigador involucrado en el proyecto Superalignment, nos advierte que estamos al borde de encontrarnos con sistemas de IA con capacidades inimaginables y actualmente carecemos de los métodos para controlarlos. OpenAI ha reconocido la importancia de este problema y ha comprometido una quinta parte de su potencia informática para esta iniciativa de investigación.

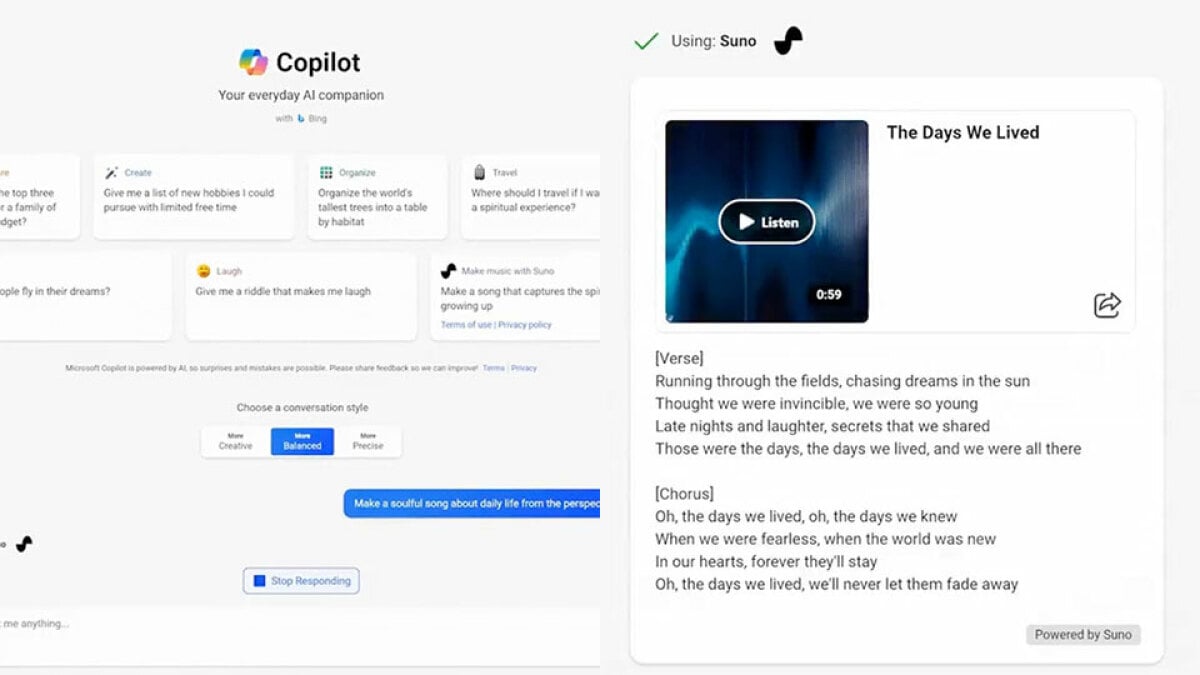

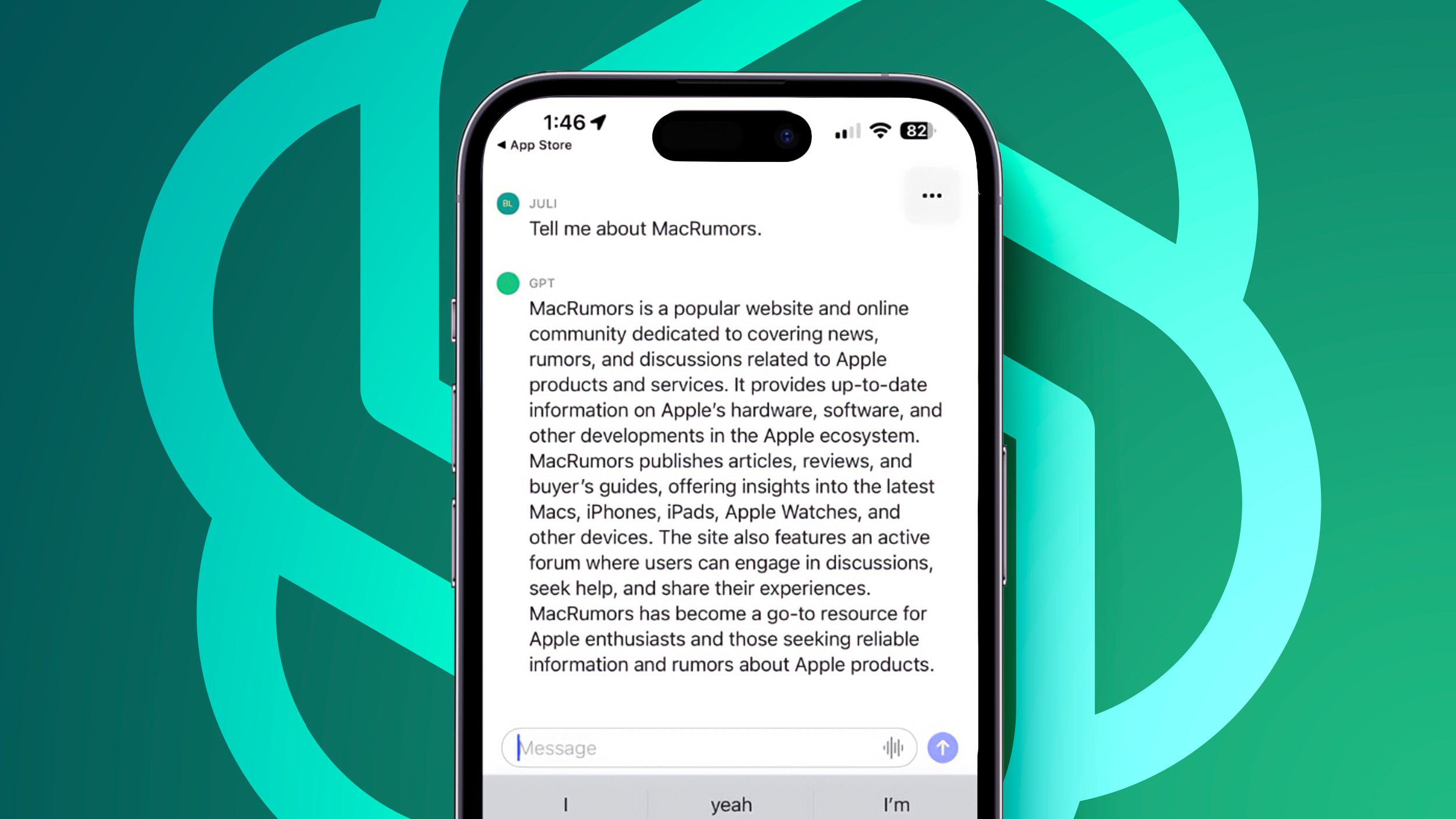

En un artículo recién publicado, OpenAI muestra experimentos realizados para probar un método que permite guiar el comportamiento de un modelo de IA inferior sin disminuir su inteligencia. Aunque la tecnología aún no es tan flexible como los humanos, sirve como una representación de un escenario futuro en el que los humanos deben colaborar con sistemas de IA que superen su propia inteligencia.

El proceso actual de ajuste de los sistemas de IA involucra la intervención humana, donde se proporciona retroalimentación sobre la calidad de sus respuestas. A medida que la tecnología de IA continúa avanzando, los investigadores están explorando formas de automatizar este ciclo de retroalimentación, tanto para ahorrar tiempo como porque puede resultar imposible para los humanos proporcionar una guía efectiva a medida que la IA se vuelve más poderosa.

Los investigadores de OpenAI llevaron a cabo un experimento de control utilizando el generador de texto GPT-2 y el nuevo modelo GPT-4 (que impulsa ChatGPT) para enseñar a GPT-4. Desafortunadamente, cuando GPT-4 aprendió de GPT-2, se volvió menos capaz y tuvo un rendimiento similar al sistema inferior. El equipo de investigación probó dos posibles soluciones. Primero, entrenaron modelos progresivamente más grandes para mitigar la pérdida de rendimiento en cada paso. En segundo lugar, agregaron un ajuste algorítmico a GPT-4, lo que permitió que el modelo más fuerte siguiera la guía del modelo más débil sin sacrificar tanto rendimiento. Este enfoque novedoso resultó más efectivo, aunque no garantiza un comportamiento impecable del modelo más fuerte. Sin embargo, sirve como un punto de partida prometedor para una investigación futura.

Dan Hendryks, el director del Centro de Seguridad de la IA, aplaude a OpenAI por abordar de manera proactiva el problema de controlar las IA superhumanas. Él enfatiza la necesidad de un esfuerzo sostenido durante muchos años para abordar este desafío con éxito.

- Rite Aid prohíbe usar tecnología de reconocimiento facial la pesadi...

- IA generativa Hype, realidad y el camino hacia adelante

- La IA no puede ser nombrada como inventora, dictamina el Tribunal S...

Los miembros del equipo de Superalignment, incluidos Collin Burns y Pavel Izmailov, expresan su optimismo sobre este importante paso inicial hacia el manejo de las posibles AI superinteligentes. Hacen una analogía sobre cómo un estudiante de sexto grado transmite sus objetivos a un estudiante universitario, a pesar de la diferencia en el conocimiento matemático. El objetivo es establecer una comunicación efectiva y una alineación entre modelos de IA menos inteligentes y más inteligentes.

El grupo Superalignment está codirigido por Ilya Sutskever, cofundador y científico jefe de OpenAI. Sutskever desempeñó un papel fundamental en el proyecto; sin embargo, no pudo ser contactado para hacer comentarios. Es importante destacar que el futuro de Sutskever en OpenAI parecía incierto después de la crisis de gobernabilidad, que resultó en el despido y posterior reintegración del CEO Sam Altman.

El concepto de utilizar un modelo de IA menos potente para controlar uno más potente no es nuevo y ha sido explorado previamente. Sin embargo, la efectividad de los métodos actuales para enseñar a la IA a comportarse de manera confiable sigue siendo incierta. Los experimentos de alineación de IA plantean preguntas sobre la confiabilidad de los sistemas de control. El enfoque de OpenAI se basa en que el modelo de IA más avanzado decida qué guía seguir del modelo más débil, lo que implica el riesgo de ignorar información que podría prevenir un comportamiento inseguro. El progreso en la garantía de la alineación será crucial para la utilidad de tales sistemas.

Destacadamente, OpenAI está buscando contribuciones externas para abordar los desafíos de controlar la IA avanzada. La compañía, en colaboración con Eric Schmidt, el influyente inversionista y ex CEO de Google, ha anunciado $10 millones en subvenciones para investigadores que propongan avances relacionados con la supervisión de débil a fuerte, la interpretabilidad de modelos avanzados y el fortalecimiento de modelos frente a indicaciones diseñadas para romper sus restricciones. OpenAI también organizará una conferencia sobre superalineación el próximo año para fomentar la colaboración e impulsar una mayor investigación en el campo.

Stuart Russell, profesor en UC Berkeley especializado en seguridad de IA, reconoce que el uso de un modelo de IA menos potente para guiar a uno más capaz se ha explorado durante algún tiempo. Sin embargo, expresa escepticismo sobre los métodos actuales para enseñar a la IA a comportarse de manera confiable. El desafío de controlar la tecnología de IA futura ha ganado una atención significativa, especialmente con el lanzamiento de ChatGPT, que ha llevado a figuras influyentes como Sutskever y Geoffrey Hinton a expresar preocupaciones sobre el rápido avance de la IA hacia el rendimiento a nivel humano.

En conclusión, el proyecto Superalignment de OpenAI representa un paso significativo hacia el manejo del poder sin precedentes de los sistemas de IA avanzados. A través de su investigación y experimentos, OpenAI tiene como objetivo establecer métodos de comunicación y control efectivos entre modelos de IA inferiores y superiores. Aunque hay desafíos e incertidumbres, OpenAI está comprometida a abordar el problema y busca activamente la colaboración con investigadores externos. El futuro del control de la IA depende de la confianza, la alineación y los esfuerzos sostenidos en esta área.

P&R:

P: ¿Qué es el proyecto de Superalineación de OpenAI? El proyecto de Superalineación de OpenAI se centra en gestionar y controlar modelos de IA altamente inteligentes que se acercan rápidamente. El objetivo del proyecto es establecer mecanismos efectivos de comunicación y control entre modelos de IA menos inteligentes y más inteligentes.

P: ¿Cómo planea OpenAI controlar la IA superinteligente del futuro? OpenAI está experimentando actualmente con métodos que permiten que los modelos de IA inferiores guíen el comportamiento de modelos más avanzados sin disminuir su inteligencia. Este mecanismo de control es un punto de partida para futuras investigaciones y tiene como objetivo prevenir las consecuencias negativas de una IA superinteligente no controlada.

P: ¿Por qué es importante controlar la IA superinteligente? Las crecientes capacidades de la IA plantean riesgos significativos si no se controlan. Una IA superinteligente no controlada podría tener consecuencias no deseadas, lo que podría llevar a acciones o comportamientos dañinos. Por lo tanto, es crucial desarrollar métodos para gestionar y controlar estos potentes sistemas de IA.

P: ¿Cómo pueden los modelos de IA más débiles guiar a los modelos de IA más fuertes? La investigación de OpenAI implica encontrar formas en las que los modelos de IA inferiores puedan proporcionar orientación a sus contrapartes más avanzadas. Al aprovechar ajustes algorítmicos y técnicas de entrenamiento, OpenAI tiene como objetivo establecer mecanismos que permitan a los modelos más débiles influir en el comportamiento de los modelos más fuertes manteniendo su rendimiento superior.

P: ¿Qué desafíos enfrenta OpenAI en el control de la alineación de la IA? Uno de los principales desafíos en la alineación de la IA es determinar hasta qué punto se debe seguir la orientación de un modelo de IA más débil por parte de un modelo de IA más fuerte. Encontrar el equilibrio adecuado puede ser difícil, ya que existe el riesgo de ignorar información que podría evitar que el modelo más fuerte se comporte de manera insegura. Lograr confiabilidad y alineación es un desafío continuo.

P: ¿Cómo pueden los investigadores externos contribuir a los esfuerzos de OpenAI? OpenAI ha anunciado una asociación con Eric Schmidt, ofreciendo $10 millones en subvenciones a investigadores externos. Buscan avances en áreas como supervisión débil a fuerte, interpretación de modelos avanzados y fortalecimiento de los modelos contra estímulos diseñados para romper sus restricciones. Esta colaboración tiene como objetivo fomentar la investigación y generar soluciones innovadoras para controlar los sistemas de IA avanzados.

P: ¿Cuál es la importancia de la conferencia de OpenAI sobre la superalineación? OpenAI planea organizar una conferencia dedicada a la superalineación, reuniendo a investigadores y expertos en el campo. Esta conferencia proporcionará una plataforma para compartir conocimientos, discutir desafíos y fomentar la colaboración. OpenAI tiene como objetivo acelerar el progreso en el control de sistemas de IA potentes a través de estos esfuerzos colaborativos.

P: ¿Cuáles son las preocupaciones en torno al control de la IA a medida que se acerca al nivel humano? Figuras destacadas dentro de la comunidad de la IA, como Ilya Sutskever y Geoffrey Hinton, han expresado preocupaciones sobre el control de la IA a medida que alcanza capacidades humanas. El avance rápido de la tecnología de IA ha generado la necesidad de mecanismos de control efectivos para prevenir consecuencias no deseadas o comportamiento inseguro de los sistemas de IA.

P: ¿Cuál es la perspectiva futura del proyecto de Superalineación de OpenAI? El proyecto de Superalineación de OpenAI representa la determinación de la compañía de abordar el control de la IA superinteligente. Con investigaciones en curso, colaboraciones con investigadores externos y financiamiento dedicado, OpenAI tiene como objetivo lograr un progreso significativo en la gestión y el control de los sistemas de IA que superan la inteligencia humana. El éxito del proyecto requerirá un esfuerzo sostenido y una estrecha colaboración dentro de la comunidad de la IA.

Referencias:

- Another Apple Designer Joins Jony Ive to Work on Hardware at OpenAI

- Recent Governance Crisis at OpenAI

- Grab an Amazon Fire TV Stick 4K for $44.99 and Watch Your Favorite Shows over the Holidays

- Threatening to Quit

- New York Times Suing OpenAI and Microsoft for Copyright Infringement

- Google Pixel Tablet Review: The Worst Pixel I’ve Ever Used – Digital Trends

- Sorry, AI – Humans Invent Things, UK Supreme Court Rules

- Increasing Worries About Controlling AI

- ChatGPT

- Deep Neural Networks

- Approaching Human Levels

No te pierdas el fascinante mundo de la IA! Comparte este artículo con tus amigos y mantente actualizado con los últimos avances tecnológicos. 😄💻🚀