IA generativa una nueva arma en el arsenal del cibercrimen 💻🔫

Algunos segmentos de código que utilizan la herramienta PowerShell de Microsoft se asemejan al estilo de salida de los grandes modelos de lenguaje.

Los cibercriminales están explotando la IA generativa de Meta’s Llama 2, según informa CrowdStrike.

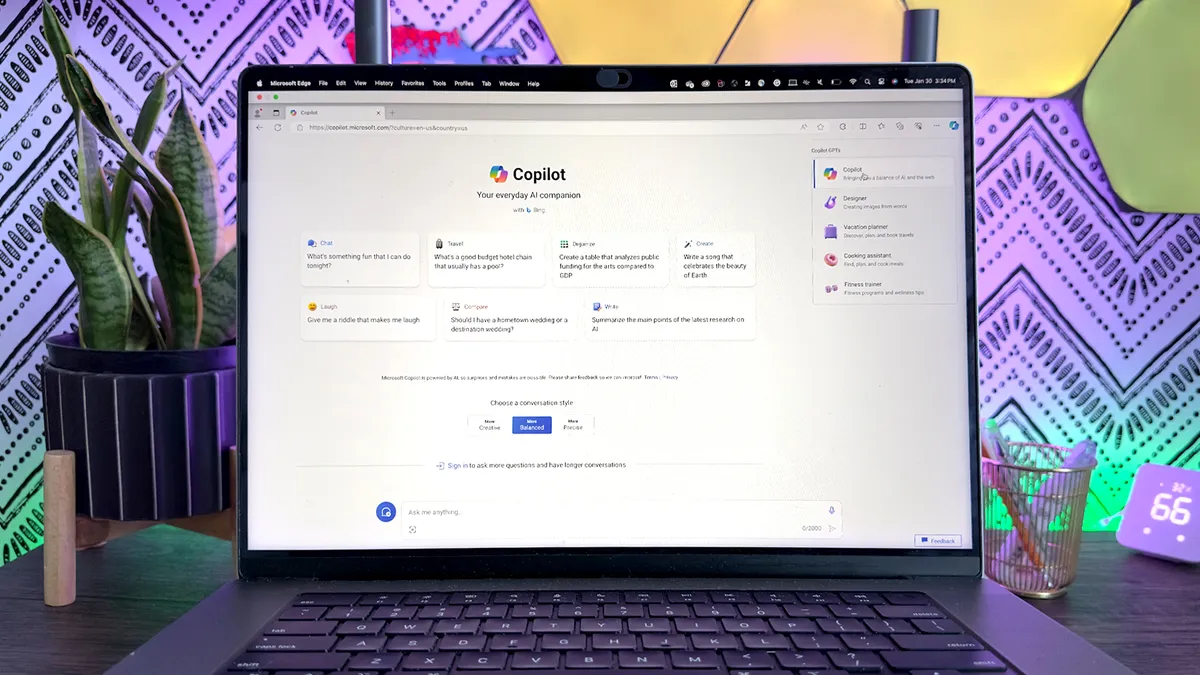

🔒 La empresa de ciberseguridad CrowdStrike ha publicado su Informe Anual de Amenazas Globales, revelando que los cibercriminales están utilizando ahora la IA generativa para llevar a cabo ataques. Un grupo, conocido como Scattered Spider, utilizó el modelo de lenguaje grande Llama 2 de Meta para generar scripts para el programa de automatización de tareas PowerShell de Microsoft. De esta manera, pudieron obtener las credenciales de inicio de sesión de empleados de una víctima de servicios financieros de América del Norte.

⚠️ El Auge de los Ataques de IA Generativa

La IA generativa, impulsada por modelos de lenguaje grande como Llama 2, permite a los cibercriminales automatizar la creación de scripts y código malicioso. Esto representa un desafío significativo para los expertos en seguridad, ya que es difícil detectar y rastrear el uso de la IA generativa en ciberataques. El estilo de código único de Llama 2 permitió identificar su uso en PowerShell, pero las observaciones concretas de tales ataques siguen siendo raras.

🚀 El Futuro del Cibercrimen

A pesar de las limitaciones actuales en la detección de ataques basados en IA generativa, CrowdStrike predice que su prevalencia seguirá creciendo. A medida que la tecnología de IA evoluciona, también lo hace su potencial para ser mal utilizada. Los hackers aprovecharán estos avances, aprovechando la IA generativa para mejorar sus ataques y desarrollar narrativas más convincentes de engaño.

- El paquete definitivo de ChatGPT e programación en Python ¡Potencia...

- 🎮 ¿Eres más negro que ChatGPT? Un juego de preguntas que expone el...

- Gen AI Confiando en la Milla de las Predicciones 🤖💪

💣 Enfrentando el Dilema Costo vs. Resultados

El alto costo de desarrollar modelos de lenguaje grande ha mitigado el alcance del daño que los cibercriminales pueden desatar con la IA generativa. Hasta ahora, la mayoría de los intentos de explotar estos modelos han dado resultados pobres o han sido obsoletos poco después de su despliegue. Sin embargo, a medida que la tecnología se vuelva más asequible y accesible, los riesgos aumentarán sin duda.

🔥 Más Allá de la Generación de Código: Desinformación y Elecciones

Además de la generación de código, el informe de CrowdStrike enfatiza el potencial de la IA generativa para ser utilizada en campañas de desinformación, especialmente durante las elecciones. Con numerosas elecciones gubernamentales teniendo lugar en todo el mundo, la amenaza de desinformación generada por IA es grande. Manipular los sistemas de votación y difundir narrativas engañosas son dos vías primarias para ciberataques en las elecciones.

🌐 El Campo de Batalla Electoral Habilitado por la Tecnología

Las “operaciones de información” (IO) que involucran IA generativa ya han sido presenciadas, con actores chinos empleando contenido generado por IA en las redes sociales para apuntar a los candidatos a la presidencia de Taiwán. CrowdStrike advierte que es probable que los adversarios utilicen estas herramientas para llevar a cabo IO en las próximas elecciones de 2024. Además, los partidarios políticamente activos en países con elecciones pueden crear desinformación a través de la IA generativa para impulsar sus propias agendas.

🔒 Protegiéndose de los Ataques Impulsados por IA

A medida que la IA generativa se convierte en un arma potente en manos de los cibercriminales, reforzar las medidas de ciberseguridad es de suma importancia. Desde sistemas avanzados de detección de amenazas hasta prácticas de codificación seguras, las organizaciones deben priorizar la protección de su infraestructura contra las emergentes amenazas impulsadas por IA.

🤔 Preguntas y Respuestas para los Lectores

P: ¿Cómo pueden las organizaciones defenderse contra los ataques de IA generativa? R: Para defenderse contra los ataques de IA generativa, las organizaciones deben invertir en sistemas robustos de detección de amenazas que puedan identificar scripts y códigos maliciosos. Además, la implementación de prácticas de codificación seguras, la realización de auditorías de seguridad regulares y mantenerse actualizados con las últimas tendencias de ciberseguridad son cruciales para prevenir y mitigar el impacto de los ataques impulsados por IA.

P: ¿Cuáles son los potenciales desarrollos futuros en los ataques de IA generativa? R: A medida que la tecnología de IA generativa continúa avanzando, podemos esperar que los cibercriminales exploten aún más sus capacidades. Desde ataques basados en IA más sofisticados que evaden las medidas de seguridad existentes hasta la creación de narrativas aún más convincentes para campañas masivas de desinformación, el futuro de los ataques de IA generativa es preocupante.

P: ¿Cómo pueden las personas protegerse de la desinformación generada por IA durante las elecciones? R: Las personas pueden protegerse de la desinformación generada por IA evaluando críticamente la información que encuentran, verificando las afirmaciones de múltiples fuentes confiables y siendo cautelosos al compartir información no verificada. Es esencial estar conscientes del potencial del contenido generado por IA para difundir narrativas engañosas y mantenerse informados sobre las medidas de seguridad implementadas por las autoridades electorales.

🔗 Referencias: – Walmart lanza IA generativa – 7 herramientas de hacking que parecen inofensivas pero pueden causar un daño real – El Llama de Código de Meta y los desafíos de la codificación de IA – Combatiendo contenido fraudulento de IA

👥 ¡Comparte tus pensamientos sobre la inteligencia artificial generativa y su impacto potencial en la ciberseguridad! ¡Mantengámonos un paso adelante de los hackers y protejamos nuestro mundo digital! 💪🔒